No mundo da ciência da computação, a eficiência é uma consideração crucial para o desenvolvimento de algoritmos e estruturas de dados. A complexidade de tempo e espaço são dois conceitos fundamentais que ajudam a avaliar o desempenho e a eficácia das soluções computacionais. Este artigo explora a importância da complexidade de tempo e espaço, como esses conceitos são aplicados ao avaliar estruturas de dados e algoritmos, e por que eles são essenciais para a criação de sistemas de software eficientes e escaláveis.

O Que é Complexidade de Tempo?

A complexidade de tempo refere-se à quantidade de tempo que um algoritmo leva para executar conforme o tamanho da entrada aumenta. É uma medida de quão rapidamente um algoritmo pode processar dados e é crucial para avaliar a eficiência do código. A complexidade de tempo é geralmente expressa em termos de notação assintótica, que descreve o comportamento do algoritmo em termos de grandes entradas.

Notações Comuns de Complexidade de Tempo:

- O(1) – Tempo Constante: Um algoritmo com complexidade O(1) executa em tempo constante, independentemente do tamanho da entrada. Isso significa que a operação leva o mesmo tempo para qualquer quantidade de dados. Exemplo: acesso a um elemento em um array.

- O(log n) – Tempo Logarítmico: Algoritmos com complexidade O(log n) reduzem o tamanho da entrada exponencialmente a cada passo. Exemplo: busca binária em um array ordenado.

- O(n) – Tempo Linear: Algoritmos com complexidade O(n) têm um tempo de execução proporcional ao tamanho da entrada. Exemplo: percorrer todos os elementos de uma lista.

- O(n log n) – Tempo Linear-Logarítmico: Algoritmos com complexidade O(n log n) são comuns em algoritmos de ordenação eficientes, como o Merge Sort e o Quick Sort.

- O(n^2) – Tempo Quadrático: Algoritmos com complexidade O(n^2) têm um tempo de execução que aumenta quadraticamente com o tamanho da entrada. Exemplo: algoritmos de ordenação por bolha e seleção.

- O(2^n) – Tempo Exponencial: Algoritmos com complexidade O(2^n) têm um tempo de execução que cresce exponencialmente com o tamanho da entrada. Exemplo: resolução de problemas combinatórios complexos.

O Que é Complexidade de Espaço?

A complexidade de espaço refere-se à quantidade de memória adicional que um algoritmo necessita em relação ao tamanho da entrada. Assim como a complexidade de tempo, a complexidade de espaço é expressa em termos de notação assintótica e é crucial para avaliar o uso eficiente da memória.

Notações Comuns de Complexidade de Espaço:

- O(1) – Espaço Constante: Um algoritmo com complexidade O(1) usa uma quantidade fixa de memória, independentemente do tamanho da entrada. Exemplo: variáveis temporárias em uma função.

- O(n) – Espaço Linear: Algoritmos com complexidade O(n) utilizam uma quantidade de memória proporcional ao tamanho da entrada. Exemplo: armazenar uma cópia de uma lista.

- O(n^2) – Espaço Quadrático: Algoritmos com complexidade O(n^2) utilizam memória que cresce quadraticamente com o tamanho da entrada. Exemplo: matrizes em algoritmos de programação dinâmica.

Avaliação de Estruturas de Dados

Escolher a estrutura de dados certa é crucial para otimizar tanto a complexidade de tempo quanto a de espaço. Aqui estão algumas estruturas de dados comuns e suas complexidades associadas:

- Arrays:

- Tempo: O(1) para acesso aleatório, O(n) para busca e inserção em geral.

- Espaço: O(n).

- Listas Ligadas:

- Tempo: O(n) para busca, O(1) para inserção e remoção em posições conhecidas.

- Espaço: O(n) com overhead adicional para ponteiros.

- Pilhas e Filas:

- Tempo: O(1) para operações básicas (push, pop, enqueue, dequeue).

- Espaço: O(n).

- Tabelas de Hash:

- Tempo: O(1) para inserção, busca e remoção em média (com boa função de hash e tabela suficientemente grande).

- Espaço: O(n) com possíveis colisões que podem degradar o desempenho.

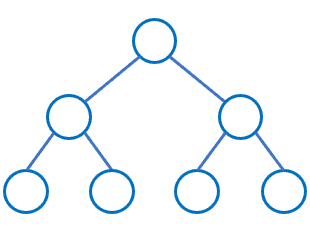

- Árvores Binárias de Pesquisa (BST):

- Tempo: O(log n) para inserção, busca e remoção em uma árvore balanceada, O(n) em uma árvore não balanceada.

- Espaço: O(n).

- Heaps:

- Tempo: O(log n) para inserção e remoção do elemento de maior prioridade, O(1) para acesso ao elemento de maior prioridade.

- Espaço: O(n).

- Grafos:

- Tempo: Varia com a representação; O(V + E) para busca em profundidade (DFS) ou busca em largura (BFS).

- Espaço: O(V + E) para representação de lista de adjacência.

Aplicações Práticas

- Algoritmos de Ordenação e Pesquisa: A escolha de algoritmos de ordenação (como Quick Sort vs. Merge Sort) e pesquisa (como busca binária vs. busca linear) depende da análise da complexidade de tempo e espaço para garantir eficiência.

- Algoritmos de Programação Dinâmica: Técnicas como memoização e tabelas de programação dinâmica podem melhorar a eficiência resolvendo subproblemas apenas uma vez e armazenando resultados, reduzindo a complexidade de tempo com um custo adicional de espaço.

- Desenvolvimento de Software e Arquitetura de Sistemas: Compreender a complexidade de tempo e espaço é essencial para o design de sistemas que precisam lidar com grandes volumes de dados e operações em tempo real, garantindo que o software seja escalável e eficiente.

Conclusão

A complexidade de tempo e espaço são conceitos fundamentais na ciência da computação que ajudam a avaliar e otimizar o desempenho de algoritmos e estruturas de dados. Compreender esses conceitos permite que desenvolvedores criem soluções mais eficientes e escaláveis, adequadas para uma ampla gama de aplicações. Ao considerar a complexidade durante o design e a implementação, é possível alcançar um equilíbrio entre desempenho e uso de recursos, resultando em sistemas de software mais robustos e eficazes.